จากโมเดลในแล็บ สู่ระบบที่ใช้งานได้จริง

บทนำ: ฮาร์ดแวร์พร้อมแล้ว แต่ AI ยัง “ไม่ตื่น”

หลังจากเราเลือกฮาร์ดแวร์ที่เหมาะสมในตอนที่ 5 คำถามถัดไปที่นักพัฒนา Edge AI ทุกคนต้องเผชิญคือ

“เราจะทำให้โมเดล AI ทำงานบนอุปกรณ์เหล่านี้ได้อย่างมีประสิทธิภาพและดูแลได้ในระยะยาวอย่างไร?”

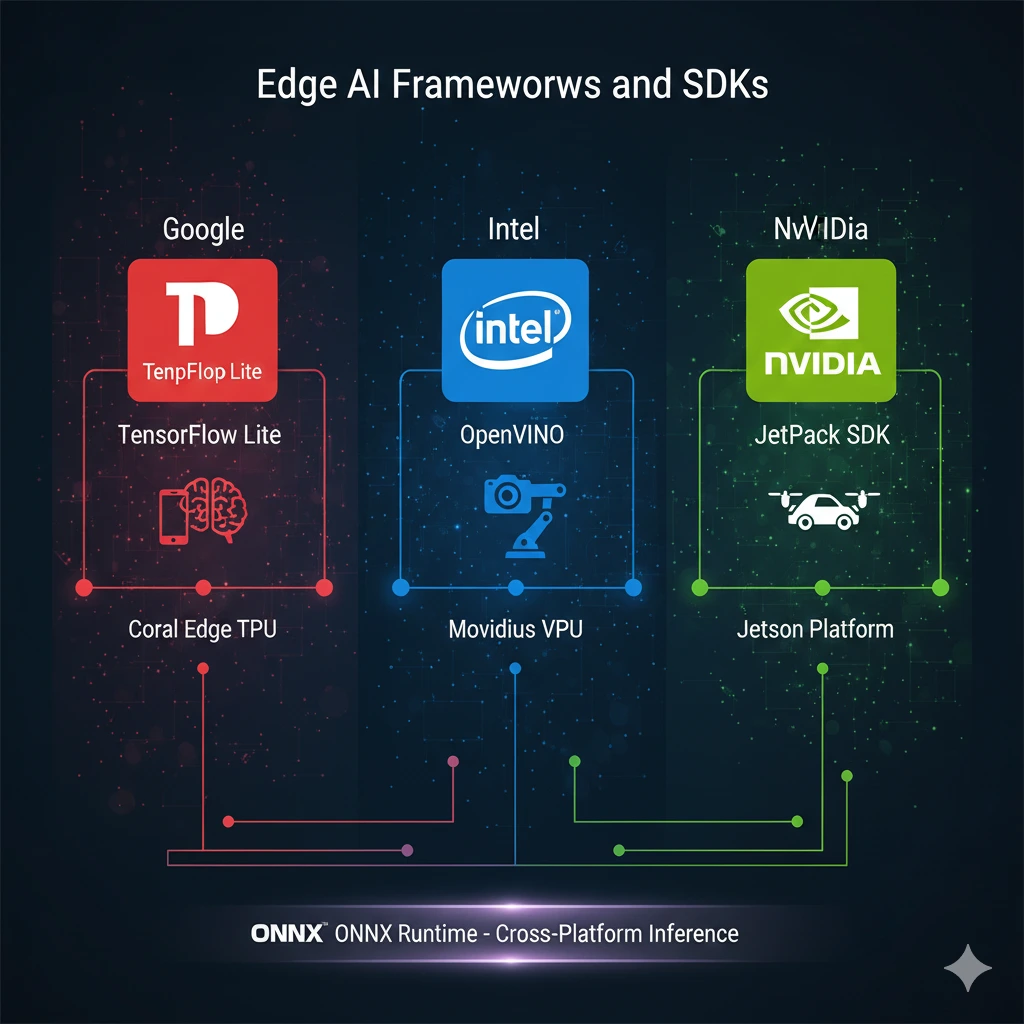

คำตอบไม่ได้อยู่ที่โค้ดเพียงไม่กี่บรรทัด แต่อยู่ที่ Frameworks และ SDKs ซึ่งทำหน้าที่เป็นสะพานเชื่อมระหว่างโลกของโมเดลกับโลกของอุปกรณ์จริง หากไม่มีเครื่องมือเหล่านี้ Edge AI จะเป็นเพียงแนวคิดที่สวยงาม แต่ไม่สามารถขยายผลในเชิงระบบได้

บทความตอนนี้จึงชวนผู้อ่านมาทำความเข้าใจว่า Frameworks สำหรับ Edge AI ไม่ได้มีหน้าที่แค่ “รันโมเดล” แต่เป็นส่วนหนึ่งของการออกแบบสถาปัตยกรรมที่ส่งผลต่อประสิทธิภาพ ความยืดหยุ่น และต้นทุนของระบบในโลกจริง

Framework สำหรับโมเดล: ทำให้ AI อยู่รอดบน Edge

ในระดับพื้นฐาน Framework สำหรับ Edge AI มีหน้าที่สำคัญคือทำให้โมเดลที่ถูกฝึกมาในสภาพแวดล้อมที่ทรัพยากรอุดมสมบูรณ์ สามารถทำงานได้บนอุปกรณ์ที่มีข้อจำกัดสูง

TensorFlow Lite เป็นหนึ่งในเครื่องมือที่ถูกใช้อย่างแพร่หลาย ด้วยแนวคิด “lean inference” โมเดลจะถูกแปลงให้อยู่ในรูปแบบที่เล็กลง รองรับการทำ quantization และสามารถรันได้ทั้งบน CPU, GPU หรือ NPU ของอุปกรณ์ Edge TensorFlow Lite จึงเหมาะอย่างยิ่งสำหรับระบบที่ต้องการ deploy จำนวนมาก เช่น กล้องอัจฉริยะหรืออุปกรณ์ IoT

ในอีกด้านหนึ่ง PyTorch Mobile ตอบโจทย์นักพัฒนาที่เริ่มต้นจาก PyTorch และต้องการนำโมเดลไปใช้งานบนอุปกรณ์ปลายทาง แม้ ecosystem บน Edge จะยังไม่กว้างเท่า TensorFlow Lite แต่ความยืดหยุ่นและความคุ้นเคยของ PyTorch ทำให้เหมาะกับงานวิจัยและการทดลองเชิงลึก

สิ่งที่น่าสนใจคือ ทั้งสองแนวทางสะท้อนการตัดสินใจเชิงกลยุทธ์ที่ต่างกัน ระหว่าง “ความพร้อมสำหรับ production” กับ “ความคล่องตัวในการพัฒนา” ซึ่งเป็นคำถามที่ทีม Edge AI ต้องตอบให้ชัดตั้งแต่ต้น

ONNX Runtime: ภาษาโลกกลางของ Edge AI

เมื่อระบบ Edge AI เติบโตขึ้น ความหลากหลายของฮาร์ดแวร์และ framework จะกลายเป็นความท้าทาย ONNX Runtime เข้ามามีบทบาทในฐานะ “ภาษากลาง” ที่ช่วยให้โมเดลสามารถรันข้ามแพลตฟอร์มได้ง่ายขึ้น

แนวคิดของ ONNX คือการแยกโมเดลออกจาก framework ที่ใช้ฝึก และเปิดโอกาสให้ผู้พัฒนาเลือก runtime ที่เหมาะกับฮาร์ดแวร์ปลายทาง เช่น CPU, GPU หรือ accelerator เฉพาะทาง วิธีคิดนี้ช่วยลด vendor lock-in และเพิ่มความยืดหยุ่นในการออกแบบระบบ

ในโลกจริง ONNX Runtime มักถูกใช้ในระบบที่ต้องรองรับอุปกรณ์หลากหลายรุ่น หรือมีแผนขยายระบบในอนาคต โดยไม่ต้องฝึกโมเดลใหม่ทุกครั้งที่เปลี่ยนฮาร์ดแวร์ (ONNX, 2023)

Edge-specific Frameworks: เมื่อ AI ต้องทำงานร่วมกับระบบจริง

แม้ framework ระดับโมเดลจะช่วยให้ AI รันได้บน Edge แต่ระบบจริงยังต้องการมากกว่านั้น ไม่ว่าจะเป็นการจัดการ deployment การอัปเดตโมเดล การสื่อสารกับ Cloud หรือการ monitor อุปกรณ์ในสนาม

AWS IoT Greengrass และ Azure IoT Edge เป็นตัวอย่างของ Edge-specific frameworks ที่มอง Edge AI เป็นส่วนหนึ่งของระบบ IT ขนาดใหญ่ ไม่ใช่เพียงแอปพลิเคชันเดี่ยว Framework เหล่านี้ช่วยให้ Edge Device สามารถรัน container หรือ function ได้อย่างเป็นระบบ พร้อมกลไกการจัดการ lifecycle และ security

ในบริบทขององค์กร Framework ลักษณะนี้ช่วยลดภาระในการดูแลอุปกรณ์จำนวนมาก และทำให้ Edge AI กลายเป็นส่วนหนึ่งของ digital infrastructure อย่างแท้จริง (Satyanarayanan, 2017)

ตัวอย่างการใช้งานเบื้องต้น: จากแนวคิดสู่การลงมือทำ

ลองจินตนาการระบบกล้องตรวจนับสินค้าในร้านค้าปลีก โมเดลถูกฝึกใน Cloud ด้วย TensorFlow จากนั้นถูกแปลงเป็น TensorFlow Lite เพื่อรันบน Edge Device เมื่อเกิดเหตุการณ์สำคัญ เช่น สินค้าขาดชั้นวาง Edge จะส่งเฉพาะ metadata ขึ้น Cloud ผ่าน AWS IoT Greengrass เพื่อประมวลผลต่อในเชิงธุรกิจ

ตัวอย่างนี้สะท้อนให้เห็นว่า Frameworks และ SDKs ไม่ได้ทำงานแยกส่วน แต่เชื่อมโยงกันเป็นห่วงโซ่ ตั้งแต่โมเดล การประมวลผล ไปจนถึงระบบบริหารจัดการ

บทสรุป: เครื่องมือคือการตัดสินใจเชิงสถาปัตยกรรม

การเลือก Framework สำหรับ Edge AI ไม่ใช่เรื่องของความนิยมเพียงอย่างเดียว แต่เป็นการตัดสินใจเชิงสถาปัตยกรรมที่ส่งผลต่อทั้งระบบในระยะยาว Framework ที่ดีจะช่วยให้ทีมพัฒนาเคลื่อนที่ได้เร็ว ระบบมีเสถียรภาพ และสามารถขยายได้โดยไม่เพิ่มความซับซ้อนเกินจำเป็น

เมื่อผู้อ่านมีภาพรวมของ TensorFlow Lite, PyTorch Mobile, ONNX Runtime และ Edge-specific frameworks แล้ว จะสามารถเริ่มต้นพัฒนา Edge AI Application ได้อย่างมีทิศทาง ไม่หลงทางในทะเลของเครื่องมือที่มีให้เลือกมากมาย

ข้อคิดทิ้งท้ายเพื่อการนำไปใช้

หากคุณต้องดูแล Edge AI ที่มีอุปกรณ์กระจายอยู่หลายร้อยจุด

คุณจะเลือก Framework ที่ “รันโมเดลได้เร็วที่สุด” หรือ Framework ที่ “ดูแลระบบได้ง่ายที่สุด” และเหตุผลใดสำคัญกว่าสำหรับบริบทของคุณ?

คำถามนี้อาจเป็นกุญแจสำคัญของความสำเร็จในโลก Edge AI

เอกสารอ้างอิง (References)

ONNX. (2023). ONNX Runtime Documentation.

TensorFlow. (2023). TensorFlow Lite Guide.

PyTorch. (2023). PyTorch Mobile Documentation.

Satyanarayanan, M. (2017). The emergence of edge computing. Computer, 50(1), 30–39.